Die Bedeutung der Weimarer Republik

Was war die Weimarer Republik?

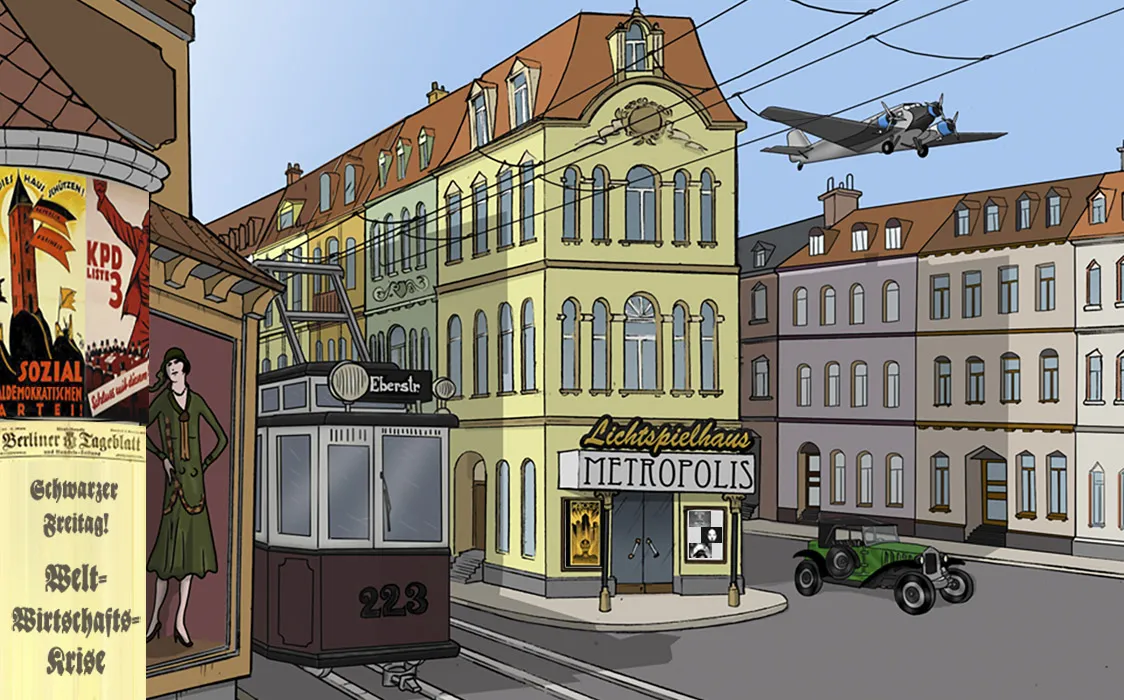

Der Beginn der Weimarer Republik war einer der großen Wendepunkte in der deutschen Geschichte: Erstmals gab es in deutschen Landen eine Republik! Heute wird das schnell vergessen, denn die Hitler-Diktatur, der Zweite Weltkrieg und natürlich die noch größere zeitliche Entfernung lassen die Erinnerung an die Weimarer Republik schwinden. Dabei ist die Weimarer Republik für die deutsche Geschichte eine Zeit, die wichtig ist für das Verständnis für das, was später passierte,

Weichen für die Zukunft

Denn diese Zeit war nicht nur ein bedeutender Einschnitt in der deutschen Geschichte, sondern es wurden auch die Weichen für die Zukunft gestellt. Die Anhänger der parlamentarischen Demokratie siegten, doch der Kampf zwischen ihnen und der Linken wurde gewaltsam niedergeschlagen. Lange prägten diese Auseinandersetzungen die Politik.

Das Ende der Weimarer Republik: auch ein Wendepunkt

Auch das Ende der Weimarer Republik markiert einen weiteren wichtigen Wendepunkt. Mit dem Ende der Republik ging die Machtübernahme Hitlers einher und damit begann eines der dunkelsten Kapitel der deutschen Geschichte.

Lernen aus der Geschichte

Aufgrund der Geschehnisse in der Weimarer Republik wurden manche ihrer Gesetze nicht in die Verfassung der Bundesrepublik übernommen. Dazu gehört zum Beispiel das Recht auf Volksentscheide. Man meinte, damit in Weimar schlechte Erfahrungen gemacht zu haben.

Die Fünf-Prozent-Hürde wurde eingeführt, damit nicht viele kleine Splitterparteien an zu großer Bedeutung gewinnen konnten und bei Abstimmungen das "Zünglein an der Waage" sein konnten. Und der Bundespräsident verfügt über weit weniger Machtbefugnisse als seine Vorgänger, die Reichspräsidenten.

Typisch Weimar?

Typisch Weimar?